реклама

Ако ти пуснете уебсайт 10 начина да създадете малък и прост уебсайт без излишната работаWordPress може да бъде излишен. Както доказват тези други отлични услуги, WordPress не е всичко и ще свърши цялото създаване на уебсайт. Ако искате по-прости решения, има разнообразие, от което да избирате. Прочетете още , вероятно сте чували за файл robots.txt (или „стандарт за изключване на роботи“). Независимо дали имате или не, време е да научите за това, защото този прост текстов файл е решаваща част от вашия сайт. Може да изглежда незначително, но може да се изненадате колко е важно.

Нека да разгледаме какво е файл robots.txt, какво прави и как правилно да го настроите за вашия сайт.

Какво е файл robots.txt?

За да разберете как работи файл robots.txt, трябва да знаете малко за търсачките Как работят търсачките?За много хора Google е интернет. Това може би е най-важното изобретение след самия Интернет. И докато търсачките са се променили много оттогава, основните принципи са все същите. Прочетете още

. Кратката версия е, че те изпращат „сканери“, които са програми, които търсят информация за интернет. След това те съхраняват част от тази информация, за да могат по-късно да насочват хората към нея.Тези сканери, известни също като "ботове" или "паяци", намират страници от милиарди уебсайтове. Търсачките им дават указания къде да отидат, но отделните уебсайтове също могат да комуникират с ботовете и да им кажат кои страници трябва да гледат.

През повечето време те всъщност правят точно обратното и им казват кои страници не трябва гледай. Неща като административни страници, странични портали, страници с категории и маркери и други неща, които собствениците на сайтове не искат да се показват в търсачките. Тези страници все още се виждат от потребителите и са достъпни за всеки, който има разрешение (което често е всеки).

Но като казва на тези паяци да не индексират някои страници, файлът robots.txt прави на всички услуга. Ако търсите „MakeUseOf“ в търсачката, бихте ли искали нашите административни страници да се показват високо в класацията? Не. Това не би помогнало на никого, затова казваме на търсачките да не ги показват. Той може да се използва и за предпазване от търсачките да проверяват страници, които може да не им помогнат да класифицират вашия сайт в резултатите от търсенето.

Накратко, robots.txt казва на уеб браузърите какво да правят.

Могат ли Crawlers да игнорират robots.txt?

Дали скалърите игнорират файловете robots.txt? Да. Всъщност много роудъри правя игнорирай го. По принцип обаче тези сканери не са от реномирани търсачки. Те са от спамерите, комбайните за електронна поща и други видове автоматизирани ботове Как да изградим основен уеб робот за изтегляне на информация от уебсайтИскали ли сте някога да заснемате информация от уебсайт? Ето как да напишете робот за навигация в уебсайт и да извлечете това, от което се нуждаете. Прочетете още които бродят в интернет. Важно е да имате това предвид - използването на стандарта за изключване на робота, за да кажете на ботовете да се пазят не е ефективна мярка за сигурност. Всъщност някои ботове могат начало със страниците, които им кажете да не отиват.

Търсачките обаче ще работят както казва файлът robots.txt, стига да е форматиран правилно.

Как да напишете файл robots.txt

Има няколко различни части, които влизат в стандартен файл за изключване на робота. Тук ще ги разбивам поотделно.

Декларация на потребителски агент

Преди да кажете на бот кои страници не трябва да гледа, трябва да посочите с кой бот говорите. През повечето време ще използвате обикновена декларация, която означава „всички ботове“. Това изглежда така:

Потребителски агент: *Звездичката означава „всички ботове“. Можете обаче да посочите страници за определени ботове. За целта ще трябва да знаете името на бота, за който определяте указания. Това може да изглежда така:

Потребителски агент: Googlebot. [списък на страниците да не обхождат] Потребителски агент: Googlebot-Image / 1.0. [списък на страниците да не обхождат] Потребителски агент: Bingbot. [списък на страниците да не обхождат]И така нататък. Ако откриете бот, който изобщо не искате да обхожда вашия сайт, можете също да го посочите.

За да намерите имената на потребителските агенти, вижте useragentstring.com [Няма по-дълги налични].

Забраняване на страници

Това е основната част от вашия файл за изключване на робота. С обикновена декларация казвате на бот или група ботове да не обхождат определени страници. Синтаксисът е лесен. Ето как ще забраните достъпа до всичко в директорията „администратор“ на вашия сайт:

Дезактивиране: / admin /Този ред ще предпази ботовете от обхождане на yourite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html и всичко останало, което попада под административната директория.

За да забраните една страница, просто я посочете в реда за забрана:

Дезактивиране: /public/exception.htmlСега страницата „изключение“ няма да бъде изтеглена, но всичко останало в папката „обществена“ ще бъде.

За да включите няколко директории или страници, просто ги избройте на следващите редове:

Дезактивиране: / частно / Дезактивиране: / admin / Дезактивиране: / cgi-bin / Дезактивиране: / temp /Тези четири реда ще се прилагат за всеки потребителски агент, който сте посочили в горната част на секцията.

Ако искате да попречите на ботовете да гледат някоя страница на вашия сайт, използвайте това:

Дезактивиране: /Задаване на различни стандарти за ботове

Както видяхме по-горе, можете да посочите определени страници за различни ботове. Комбинирайки предишните два елемента, ето как изглежда:

Потребителски агент: googlebot. Дезактивиране: / admin / Дезактивиране: / private / User-agent: bingbot. Дезактивиране: / admin / Дезактивиране: / частно / Дезактивиране: / тайна /Секциите „администратор“ и „частни“ ще бъдат невидими в Google и Bing, но Google ще види „секретната“ директория, докато Bing няма.

Можете да зададете общи правила за всички ботове, като използвате потребителския агент на звездичка, и след това да дадете конкретни инструкции на ботовете в следващите секции.

Поставяме всичко заедно

Със знанията по-горе можете да напишете пълен файл robots.txt. Просто запалете любимия си текстов редактор (ние сме фенове на Sublime 11 Съвети за възвишен текст за производителност и по-бърз работен процесSublime Text е универсален текстов редактор и златен стандарт за много програмисти. Нашите съвети се фокусират върху ефективното кодиране, но общите потребители ще оценят клавишните комбинации. Прочетете още тук) и започнете да съобщавате на ботовете, че не са добре дошли в определени части на вашия сайт.

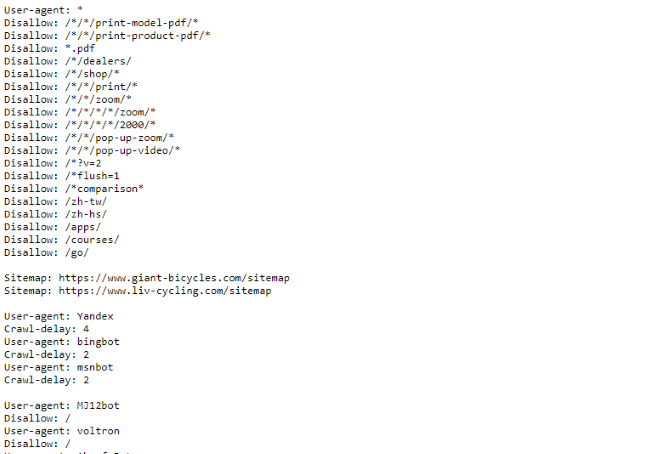

Ако искате да видите пример на файл robots.txt, просто се насочете към всеки сайт и добавете „/robots.txt“ в края. Ето част от файла Giant Bicycles robots.txt:

Както можете да видите, има доста страници, които не искат да се показват в търсачките. Те също са включили няколко неща, за които все още не сме говорили. Нека да разгледаме какво още можете да направите във вашия файл за изключване на робота.

Намиране на вашата Sitemap

Ако вашият файл robots.txt казва на ботове къде не да отида, твоята sitemap прави обратното Как да създадете XML Sitemap в 4 лесни стъпкиИма два типа Sitemap - HTML страница или XML файл. HTML Sitemap е една страница, която показва на посетителите всички страници на уебсайт и обикновено има връзки към тези ... Прочетете още и им помага да намерят това, което търсят. И докато търсачките вероятно вече знаят къде е вашата карта на сайта, не боли да ги уведомите отново.

Декларацията за местоположение на карта на сайта е проста:

Карта на сайта: [URL на сайта на сайта]Това е.

В нашия собствен файл robots.txt изглежда така:

Карта на сайта: //www.makeuseof.com/sitemap_index.xmlТова е всичко, което има за него.

Задаване на забавяне на обхождането

Директивата за забавяне на обхождането казва на определени търсачки колко често те могат да индексират страница на вашия сайт. Той се измерва за секунди, въпреки че някои търсачки го интерпретират малко по-различно. Някои виждат забавяне на обхождането от 5, като им казват да изчакат пет секунди след всяко обхождане, за да инициират следващото. Други го интерпретират като инструкция да обхождате само една страница на всеки пет секунди.

Защо бихте казали на даден робот да не пълзи максимално? Да се запазване на честотната лента 4 начина Windows 10 губи вашата интернет лентаWindows 10 губи ли вашата интернет честотна лента? Ето как да проверите и какво можете да направите, за да го спрете. Прочетете още . Ако вашият сървър се бори да бъде в крак с трафика, може да искате да установите забавяне на обхождането. По принцип повечето хора не трябва да се притесняват от това. Големите сайтове с голям трафик обаче може да искат да експериментират малко.

Ето как зададете закъснение на обхождане от осем секунди:

Закъснение при обхождане: 8Това е. Не всички търсачки ще се подчиняват на вашата директива. Но не боли да питаш. Както при забрана на страниците, можете да зададете различни закъснения при обхождане за конкретни търсачки.

Качване на вашия файл robots.txt

След като инсталирате всички инструкции във вашия файл, можете да го качите на вашия сайт. Уверете се, че това е обикновен текстов файл и има името robots.txt. След това го качете на вашия сайт, така че да може да бъде намерен на вашия сайт.bg/robots.txt.

Ако използвате a система за управление на съдържанието 10 най-популярни системи за управление на съдържанието онлайнДните на ръчно кодирани HTML страници и овладяване на CSS са отдавна отминали. Инсталирайте система за управление на съдържанието (CMS) и след минути можете да имате уебсайт, който да споделяте със света. Прочетете още като WordPress, вероятно има конкретен начин, по който трябва да се справите с това. Тъй като тя се различава във всяка система за управление на съдържанието, ще трябва да се консултирате с документацията за вашата система.

Възможно е някои системи да имат и онлайн интерфейси за качване на вашия файл. За това просто копирайте и поставете файла, който сте създали в предишните стъпки.

Не забравяйте да актуализирате вашия файл

Последният съвет, който ще ви дам, е от време на време да преглеждате вашия файл за изключване на робота. Вашият сайт се променя и може да се наложи да направите някои корекции. Ако забележите странна промяна в трафика на вашата търсачка, добре е да проверите и файла. Възможно е също така стандартната нотация да се промени в бъдеще. Както всичко останало на вашия сайт, струва си да го проверявате всеки път.

От кои страници изключвате роботите на вашия сайт? Забелязали ли сте някаква разлика в трафика на търсачките? Споделете вашите съвети и коментари по-долу!

Дан е стратегия за съдържание и маркетингов консултант, който помага на компаниите да генерират търсене и да водят. Той също така блогове за стратегия и маркетинг на съдържанието в dannalbright.com.